Robots.txt kurz erklärt

Die robots.txt Datei ist eine Textdatei (.txt) die sich im Hauptverzeichnis einer Website befinden soll. (www.domain.com/robots.txt). Mit der robots.txt Datei kann man steuern, welche Suchmaschinenbots welche Bereiche der eigenen Website besuchen (crawlen) dürfen und welche nicht. Diese Angaben werden mit verschiedenen Direktiven gemacht.

Jede Anweisung in einer robots.txt-Datei besteht aus zwei Teilen: dem User-Agent und mindestens einer Direktive wie “Disallow” oder “Allow”.

- Der “User-Agent” bezieht sich auf den spezifischen Web-Crawler, zu dem die Anweisung gehört (zum Beispiel Googlebot für Google’s Crawler).

- “Disallow” wird verwendet, um den Zugriff auf ein bestimmtes Verzeichnis oder eine Datei zu verhindern.

- “Allow” wird hauptsächlich in Verbindung mit “Disallow” verwendet, um den Zugriff auf bestimmte Dateien innerhalb eines disallowed Verzeichnisses zu ermöglichen.

Sie spielt eine entscheidende Rolle in der Suchmaschinenoptimierung und im Management von Web-Crawlern. Dieser Artikel richtet sich an Webmaster, SEO-Spezialisten und alle, die ihre Website gezielt für Suchmaschinen wie Google und Bing optimieren möchten. Erfahren Sie, wie Sie durch die richtigen Anweisungen in der robots.txt-Datei die Indexierung Ihrer Site steuern können. Bleiben Sie dran, um Ihr SEO-Potential voll auszuschöpfen.

Die Grundlagen

Diese Textdatei gibt wie erwähnt Anweisungen an Webcrawler, welche Bereiche einer Website sie erfassen dürfen und welche nicht.

Die Datei sollte im Hauptverzeichnis der Website platziert werden, denn nur so können Suchmaschinen sie finden und die Anweisungen entsprechend interpretieren. Die korrekte Platzierung und Formulierung der Anweisungen ist entscheidend, da Fehler dazu führen können, dass Inhalte entweder fälschlicherweise von der Indizierung ausgeschlossen werden oder private bzw. sensible Bereiche einer Website unbeabsichtigt zugänglich gemacht werden.

- Ein typisches Beispiel für eine Anweisung ist das Verbot des Zugriffs auf ein bestimmtes Verzeichnis. Dies geschieht durch die Nutzung des „Disallow„-Befehls. Umgekehrt kann man bestimmten Bots auch explizit erlauben, bestimmte Inhalte zu crawlen, indem man sie mit „Allow“ freigibt. Es ist allerdings wichtig zu verstehen, dass die Direktiven in der robots.txt eher als Richtlinien denn als strikte Regeln fungieren. Das bedeutet, dass nicht alle Bots sich an die Vorgaben halten. Vor allem schädliche Bots, die Daten scrapen oder Spam verbreiten, ignorieren die Datei häufig.

- Es ist auch möglich, mit der „User-agent„-Direktive spezifische Anweisungen für verschiedene Crawler zu definieren. So kann man differenziert festlegen, welcher Suchmaschinen-Bot welchen Bereich der Website erfassen darf und welcher nicht. Dies ermöglicht eine feinere Steuerung des Crawling-Prozesses.

- Ein weiterer wichtiger Punkt ist die Aktualisierung. Mit der Weiterentwicklung oder Umstrukturierung einer Website sollten auch die Einträge in der robots.txt überprüft und gegebenenfalls angepasst werden. Veraltete Anweisungen können sonst dazu führen, dass neue oder aktualisierte Seiten von Suchmaschinen ignoriert werden.

Es gibt Tools und Online-Validatoren, mit denen Webmaster ihre robots.txt auf Fehler überprüfen können. Diese Werkzeuge sind sehr nützlich, um gängige Fehler wie Tippfehler, falsche Verwendung von Wildcards oder Syntaxfehler zu identifizieren und zu korrigieren. Auch in der Google Search Console (GSC) gibt es ein sehr gutes Testing-Tool, das wir sehr empfehlen können, um die eigene robots.txt zu prüfen. Dafür muss die Search Console jedoch eingerichtet sein.

Neben der robots.txt Analyse findet man in der GSC noch viele weitere wichtige Informationen rund um das Thema Webcrawler, Robots, 404 Seiten, rankende Keywords, Pagespeed und noch vieles mehr. Ein Besuch im Google Search Central ist für jeden interessierten SEO also Pflicht.

User-Agent: Die Zielgruppe definieren

In der robots.txt-Datei können Sie mithilfe des User-Agent-Eintrages bestimmte Suchmaschinenbots ansprechen. Beispiel: User-Agent: Googlebot wendet sich nur an den Google Crawler, während User-Agent: * alle Bots inkludiert.

Beispiele für beliebte User-Agents:

- Googlebot: Der Crawler von Google, der für das Indizieren von Webseiten für die Google-Suche verwendet wird.

- Bingbot: Der Crawler von Microsoft Bing.

- Yahoo! Slurp: Der Crawler von Yahoo für die Indizierung von Webseiten.

- DuckDuckBot: Der Crawler der Suchmaschine DuckDuckGo.

- Baiduspider: Der Crawler der chinesischen Suchmaschine Baidu.

- YandexBot: Der Crawler der russischen Suchmaschine Yandex.

- Facebookexternalhit: Verwendet von Facebook, um Informationen und Bilder von Webseiten für die Vorschau in sozialen Medien zu erfassen.

- Twitterbot: Verwendet von Twitter, um Inhalte von Webseiten zu erfassen, die in Tweets geteilt werden.

- LinkedInBot: Der Crawler von LinkedIn, der für das Indizieren von Webseiten für das professionelle Netzwerk verwendet wird.

- Googlebot-Image: Speziell für das Indizieren von Bildern für die Google Bildersuche.

Disallow & Allow: Zutritt verwalten

Mit Disallow: /privat/ verhindern Sie beispielsweise, dass Suchmaschinen den Inhalt des Verzeichnisses /privat/ indexieren.

Umgekehrt erlaubt Allow: /bilder/ den Bots explizit, das Verzeichnis /bilder/ zu crawlen.

Weitere Direktiven im Robots Exclusion Protocol (REP)

- Crawl-Delay: Diese Anweisung gibt an, wie viele Sekunden ein Crawler warten sollte, bevor er Anfragen an den Server sendet. Dies kann helfen, die Serverlast zu verringern.

- Sitemap: Hier kann die URL zur XML-Sitemap angegeben werden. Dies hilft Suchmaschinen, alle Seiten der Website zu finden und zu indizieren.

- Noindex: Obwohl dies nicht offiziell Teil des Protokolls ist und von den meisten Suchmaschinen nicht beachtet wird, nutzen einige Webmaster diese Direktive in der Hoffnung, dass es Seiten vor der Indizierung schützt.

- Host: Wird manchmal verwendet, um die bevorzugte Hauptdomain anzugeben, falls eine Website über mehrere Domains verfügbar ist.

Die 3 häufigsten Fehler bei der Anwendung der robots.txt Datei

- Falsche Verwendung von Wildcards: Wildcards wie das Asterisk (*) und Dollarzeichen ($) werden oft falsch platziert, was zu ungewolltem Crawling oder Blockieren von URLs führen kann.

- Verbot wichtiger Inhalte: Manchmal werden versehentlich wichtige Seiten oder Ressourcen blockiert, die für das ordnungsgemäße Indizieren der Website erforderlich sind.

- Syntaxfehler: Einfache Tipp- oder Formatierungsfehler können dazu führen, dass Anweisungen falsch interpretiert werden oder die Datei von Suchmaschinen-Crawlern ignoriert wird.

Beispiele für die Nutzung der robots.txt:

Einige konkrete Beispiele:

# Alle Bots vom Crawlen ausschließen

User-Agent: *

Disallow: /

# Google Bots vom Crawlen eines Verzeichnisses ausschließen

User-Agent: Googlebot

Disallow: /privat/

# Bestimmten Crawler vom Crawlen einer einzelnen Datei ausschließen

User-Agent: Bingbot

Disallow: /verzeichnis/datei.html

# Crawl-Delay für alle Bots setzen

User-Agent: *

Crawl-Delay: 10

# Sitemap angeben

Sitemap: http://www.beispiel.de/sitemap.xmlDiese Beispiele verdeutlichen, wie flexibel die robots.txt-Datei genutzt werden kann, um das Verhalten von Suchmaschinenbots zu steuern. Es ist jedoch wichtig zu beachten, dass nicht alle Bots die in der robots.txt festgelegten Regeln befolgen und dass Disallow-Anweisungen keine Sicherheitsgarantie darstellen. Sensible Inhalte sollten daher immer zusätzlich durch passende Sicherheitsmaßnahmen geschützt werden.

Zusatzinfo: Man kann auch spezielle Dateitypen vom Crawling ausschließen

User-agent: *

Disallow: /*.pdf$

Disallow: /*.doc$

Disallow: /*.jpg$

Diese Einträge in der robots.txt verhindern, dass Suchmaschinen-Crawler auf PDF-, DOC- und JPG-Dateien zugreifen, die auf der Website gehostet werden.

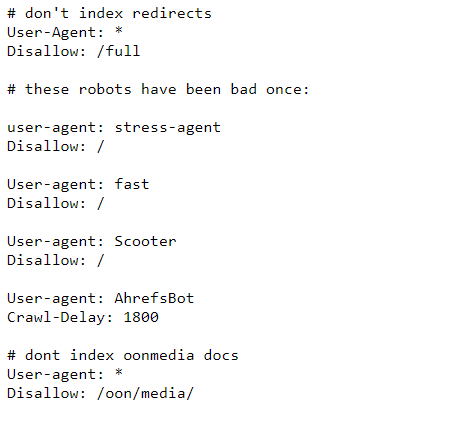

Ein Beispiel aus der Praxis – Die robots.txt Datei von orf.at (Abrufdatum 17.10.2023)

Kannst du schon alles entziffern? 🙂

Teste dein robots.txt Wissen

Achtung: Crawling ist nicht gleich Indexierung!

Die robots.txt-Datei gibt zwar an, auf welche Bereiche einer Website Suchmaschinen-Crawler zugreifen dürfen und welche Bereiche sie nicht crawlen sollen. Crawling ist der Prozess, bei dem ein Bot einer Suchmaschine Informationen über neue und aktualisierte Seiten sammelt, um sie später zu indexieren. Wenn eine Seite gecrawlt wird, bedeutet das jedoch nicht automatisch, dass sie auch indexiert und in den Suchergebnissen angezeigt wird.

Jede Robots.txt Datei ist individuell

Tatsächlich ist jede robots.txt Datei so einzigartig wie die Website, für die sie erstellt wurde. Diese Datei dient als Richtlinie für Suchmaschinen-Crawler und legt fest, welche Bereiche einer Website indexiert werden dürfen und welche nicht. Es gibt keinen universellen Standard für robots.txt, da die Bedürfnisse einer Website stark variieren können. Zum Beispiel möchte eine E-Commerce-Plattform vielleicht verhindern, dass Suchmaschinen vertrauliche Kundeninformationen indexieren, während ein Blog möglicherweise wünscht, dass alle Seiten für eine breite Sichtbarkeit erfasst werden.

Die Erstellung erfordert daher eine sorgfältige Analyse der Website-Struktur und der Ziele des Seitenbetreibers. Es gilt zu entscheiden, welche Bereiche der Website öffentlich zugänglich sein sollen und welche Daten geschützt werden müssen. Zudem müssen die Auswirkungen auf SEO bedacht werden, da eine zu restriktive Anweisung die Sichtbarkeit in Suchmaschinen einschränken kann.

FAQs zum Thema robots.txt

Frage: Was geschieht, wenn keine robots.txt-Datei vorhanden ist?

Antwort: Sind keine Anweisungen über eine robots.txt-Datei festgelegt, können Bots theoretisch alle Bereiche Ihrer Website crawlen.

Frage: Wie erstelle ich eine robots.txt-Datei?

Antwort: Eine robots.txt ist eine einfache Textdatei, die Sie mit einem Texteditor erstellen und im Hauptverzeichnis Ihrer Domain platzieren können.

Frage: Kann ich mit robots.txt auch bestimmte Dateitypen blockieren?

Antwort: Ja, Sie können spezifische Dateiendungen mit Disallow in Ihrer robots.txt ausschließen, um diese vom Crawlen auszuschließen.

Frage: Was sollte ich tun, wenn ich nicht möchte, dass eine Seite indexiert wird?

Antwort: Nutzen Sie den Noindex-Befehl in der Meta Robots-Tag auf der Seite selbst zusätzlich.

Hilfreiche Links und Quellen:

- Google Developers Guide: Dieser Leitfaden von Google enthält detaillierte Anweisungen zur Erstellung einer Robots.txt-Datei.

- MOZ: Ein sehr nützlicher Artikel, der erläutert, wie man eine Robots.txt-Datei für SEO-Zwecke optimal einsetzt.

- Ryte: Ein weiterer hilfreicher Leitfaden, der sich auf die technischen Aspekte der Erstellung und Verwendung von Robots.txt konzentriert.

- Github.com: Liste mit „schlechten Bots“, die man meist sperren will